《人工智能 机器学习与神经网络》刘峡壁,马霄虹,高一轩|(epub+azw3+mobi+pdf)电子书下载

图书名称:《人工智能 机器学习与神经网络》

- 【作 者】刘峡壁,马霄虹,高一轩

- 【页 数】 358

- 【出版社】 北京:国防工业出版社 , 2020.08

- 【ISBN号】978-7-118-12120-9

- 【分 类】人工智能-人工神经网络-机器学习

- 【参考文献】 刘峡壁,马霄虹,高一轩. 人工智能 机器学习与神经网络. 北京:国防工业出版社, 2020.08.

图书封面:

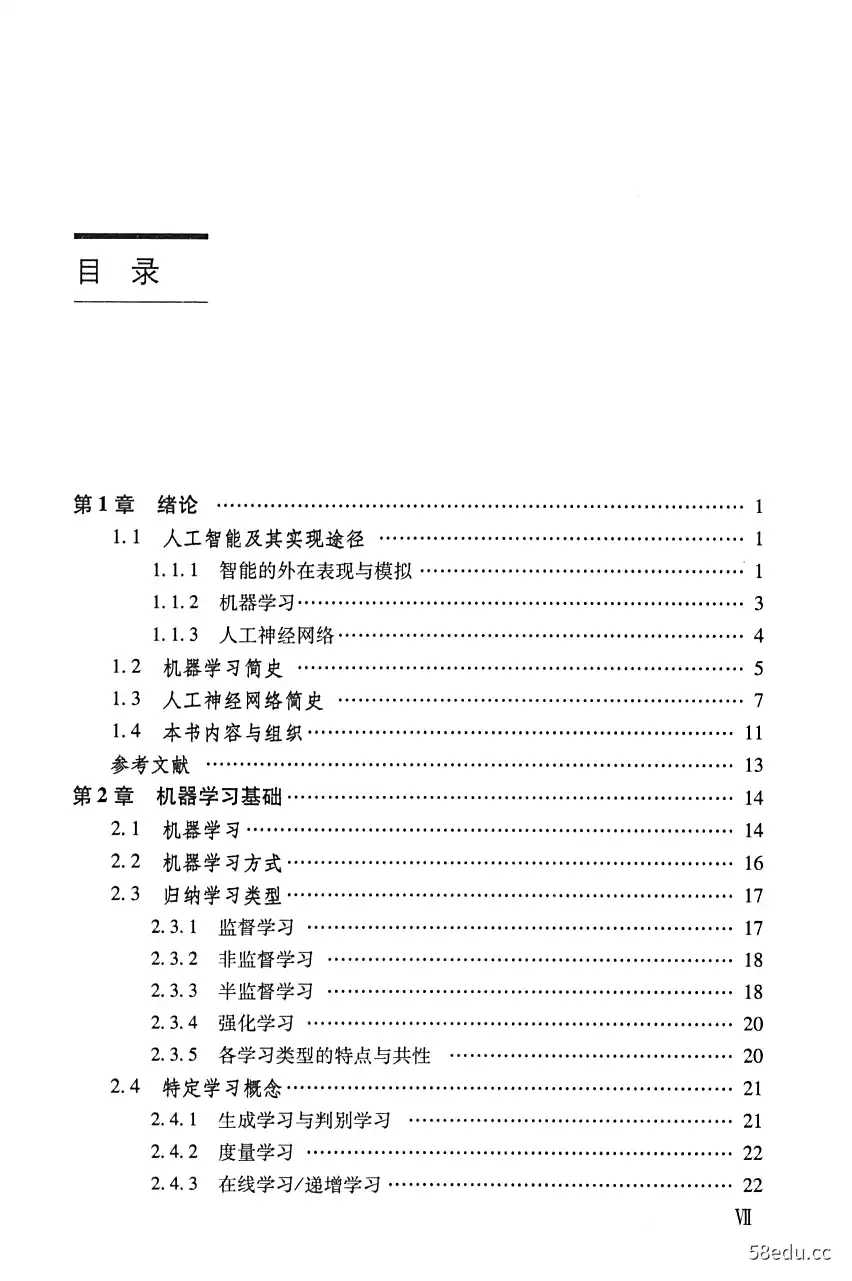

图书目录:

《人工智能 机器学习与神经网络》内容提要:

本书以人工智能实现算法为视角,系统阐述机器学习与人工神经网络这两个彼此紧密联系的人工智能实现途径中的主要问题与解决方法。对于机器学习,在深入理解机器学习任务与关键问题的基础上,探讨监督学习、非监督学习、半监督学习、强化学习这四大类归纳学习问题的本质特性及其解决方案,同时论述作为归纳学习基础的相似性计算问题及其解决方法。对于人工神经网络,按照其关键问题是网络拓扑结构与学习方法的认识,分为前馈网络与反馈网络这两大类网络结构,阐述主要计算模型及其学习方法。最后对机器学习与人工神经网络下一步的发展趋势进行了展望。

《人工智能 机器学习与神经网络》内容试读

第1章绪论

人工智能(Artificial Intelligence,AI)在政府的大力推动下,摇旗呐喊者众多。但人工智能目前所处的发展阶段及其发展的历史经验告诉我们:距离人类真正理解人类智能进而完成人工智能还有漫漫长路要走,而且高潮过后会有低点。

AI自1956年成为一门独立学科以来,几经起伏,但始终向前,因为它承载着人

类认识自身探索自身的梦想,正如刻在希腊帕台农神庙上的那句箴言:认识你自已(know yourself),这一过程永远不会停止。

人工智能技术目前还主要停留在算法实现阶段,各种思想和方法最终都是通过计算手段,依托于计算平台来实现的,具体表现为计算平台上的人工智能算法程序。本书从算法的视角,阐述机器学习与人工神经网络这两个彼此紧密联系的人工智能技术分支中的问题、思路与方法,希冀在人类探索人工智能的过程中发一点微光,照亮自己前行的路,如能更因此惠及读者,则福莫大焉。

1.1人工智能及其实现途径

人工智能是对生物智能,特别是人类智能的模拟。目前,我们对生物智能本身还知之甚少。智能的本质究竟是什么?起源在哪里?对此,我们还缺乏基本的认识。我们只能看到智能的表现,看到人类或其他生物智能体身上区别于非智能体的能力,而看不到智能本身,就像柏拉图的“洞穴比喻”四,我们还只能在洞中观察智能投射在墙壁上的影子,而不知道洞穴外那个真正的智能的样子。终有一天,有人会蓦然回首,转身瞥见洞穴外的真象,到那时或许会推翻今天人们对人工智能的所有认识。

1.1.1智能的外在表现与模拟

目前,智能外在表现主要体现在以下能力上。

(1)感知能力。感知能力是指人们通过视觉、听觉、嗅觉、味觉、触觉等感觉器官感知外部世界的能力,不仅获得相应信息,而且获得对于相应信息的理解,能够将所感知到的原始信息认知为相应的语义结果,如认知视觉信息中的物体

2

人工智能—机器学习与神经网络

与场景、理解语言背后的含义等。

(2)行为能力。行为能力是指人们在感知外界信息的基础上,运用语言、表情、肢体、动作等行动手段,对环境变化做出反应的能力,而通过行动,行动者亦使外界环境发生了相应变化,同时行动者可能从外界环境中获得某种收益或损失,如行走时摔倒、开车时撞人等。

(3)推理能力。推理能力是指人们从所掌握的事实中获得适当结论的能力,从案件侦办、定理证明等典型推理问题中可获得对于这种能力的认识。

(4)问题求解能力。问题求解能力是指人们针对特定问题找出解决方案的能力,如对于下棋,人们要解决问题的是如何赢棋,针对该问题的解决,寻求最佳的下棋应对策略。

(5)学习能力。学习能力是指人们通过向经验学习、向老师学习、向书本学习等各种学习手段,使得自身某一方面的能力和水平或者综合素质越来越强的能力,最终目标是能够更好地完成任务和适应环境。

(6)社交能力。社交能力是指人们通过群体协作来共同解决问题的能力。没有人能孤立的生活在世界上,人类的力量在于群体的力量,离开了人类社会,每个个体都是渺小的,难以战胜自然界中的各种困难。除了人类,其他生物亦往往是群体性的,甚至群体智慧的重要性要远远超过个体智慧,这在蚂蚁、蜜蜂、大雁等群居性动物中体现得尤为充分。

(7)创造能力。创造能力是指人们能够创造出前所未有的思想或事物的能力。我们能够创作出美妙的乐曲、优美的诗篇,能够发明种种新奇的器物,能够发现这个世界中存在的种种定律、规则,能够提出启发或激励后人的种种思想·。这大概是智能的外在表现中最难以理解和实现的部分。

基于我们还只能了解智能的外在表现这一事实,人工智能的发展主要是在模拟上述能力的过程中发展起来的,并衍生出了诸多分支学科,或者与诸多分支学科交叉在一起。对于感知能力的模拟,有计算机视觉、模式识别、自然语言理解等;对于行为能力的模拟,有机器人、自动控制等;对于推理能力的模拟,有自动定理证明、专家系统、知识工程等:对于问题求解能力的模拟,有机器博弈、游戏智能等;对于学习能力的模拟,有机器学习、数据挖掘、知识发现等;对于社交能力的模拟,有分布式人工智能、群智能等。在这些分支学科中各有特殊的问题待解决,有些不一定与智能直接相关,而只是智能的外围部件,比如与感知有关的各种传感器、与行为有关的各种效应器等。而人工智能本身则是讨论在模拟这些能力时所需要的与智能紧密相关的部分,尤其是偏重无形思考的部分,或者具象上类似软件的部分。这样逐渐发展出了六大人工智能实现途径:机器学习、人工神经网络、符号智能、行为智能、进化计算、群智能。这六大途径与智能的上

第1章绪论

3

述外在表现之间的关系,可归纳为以下三类:

(1)对智能外在表现的直接模拟,包括机器学习(学习能力)、群智能(社交能力)、行为智能(行为能力);

(2)提供模拟智能外在表现的基础支撑,包括人工神经网络(人脑结构)、进化计算(智能进化机制);

(3)基于现有计算机来模拟智能外在表现,如符号智能(基于计算机符号处理的特性)。

本书涉及以上实现途径中的机器学习与人工神经网络,下面对二者做一简要介绍,作为本书内容的起点。关于其他途径,请读者参阅相关书籍2]。

1.1.2机器学习

学习是人类获取知识、增长智力的根本手段。人们从呱呱落地、一无所知的婴儿,成长为能解决各种问题乃至能创造新生事物的万物灵长,所依靠的正是强大的学习能力。因此,通过机器学习实现人工智能是一种自然的想法和一条必经的道路。可以设想一种婴儿机器(child machine),该机器通过从自我经验中学习、从书本上学习、向老师学习、向他人学习等学习手段,像人一样逐渐成长,不断地增长其智力,直至能够很好地解决任务和适应环境。

相信“婴儿机器”的设想最终是能够实现的,但就目前的现状而言,我们对人类学习机理、方法以及如何实现等问题的认识还处在非常初级的阶段,就连婴儿是如何从经验中进行学习的问题,也还知之甚少。事实上,赋予机器以学习能力是涉及人类智能本质的根本性问题,也是一个非常困难的问题,对这一问题的解决或许意味着真正的人工智能的到来。同时,这也是人工智能中一个难以绕开的问题,在人工智能的诸多分支中,由于对环境的不可预知、系统的过于复杂、数据量的过于庞大等因素,需要依靠机器学习技术来构建和优化系统。因此,随着人工智能各个分支的不断进步,机器学习技术的应用范围不断扩大,重要程度不断上升,相关研究将为“婴儿机器”设想的最终实现奠定理论与技术基础。

就像人类在不同成长阶段会使用不同的学习手段一样,机器学习也有着与之类比的不同学习方法。首先是强化学习方法,一种机器根据自身行动所获得的收益和惩罚来学习最优行为策略的学习方法。这与人类婴幼儿时期的主要学习方法是类似的,在这一时期,人类理解能力还不够,只能从外界环境反馈中知道对错,比如获得奖励或者被训挨打等,从而优化自己的行为,趋利避害。其次是监督学习方法,类似于人类的求学阶段,通过老师在所讲授的课程,学生能建立起问题与问题答案之间的联系,从而学到老师希望学生学到的东西。机器的监督学习方法与此相同,这种问题与问题答案对应的数据称为标注数据。再次是

4

人工智能—机器学习与神经网络

非监督学习方法,只有输入数据,没有与之对应的标准答案,也没有对与错的反馈需要机器自动从数据中获得有规律的知识,分为数据分布规律和数据关联规则两大类知识,其中第一类对应数据聚类问题,第二类对应关联规则挖掘问题。最后,还可将监督学习与非监督学习方法结合起来使用,先在少量标注数据上进行监督学习,再在大量未标注数据上进行非监督学习,相应方法称为半监督学习方法。

目前对于机器学习的认识,集中在上述四种学习方法上。

1.1.3人工神经网络

人工神经网络是以对大脑结构的模拟为核心的人工智能实现途径,试图在模拟大脑结构的基础上再模拟其思考能力,因此是一种自下而上的实现方法,这与符号智能首先关注功能再考虑算法结构的自上而下实现方式正好相反。由于大脑是通过大量神经元连接而成,人工神经网络也是通过大量人工神经元相互连接而形成的网络,因此该实现途径也常被称为“连接主义”。

人工神经网络既然是对大脑结构的模拟,因此第一个核心问题是网络结构问题,包括神经元如何构造、神经元之间如何连接、整体结构如何设计等。在这些问题上,人工神经元的形态目前基本固定,被认为是一个计算单元,是由一个整合函数与一个激活函数复合而成的计算函数。而在神经元连接与整体结构上,则存在较多的探索与变化,可分为前馈网络和反馈网络两种大的结构类型,前馈网络又可分为感知器、多层感知器、反向传播网络、深度网络、自组织映射网、径向基函数网络等具体形态,反馈网络又可分为稳定型反馈网络与时序型反馈网络两种子类。目前,深度网络大行其道,在很多应用中表现优异,几乎快成了人工神经网络乃至人工智能的代名词。但我们不应因此忽视其他网络类型,尤其是反馈网络,更不应忽视其他人工智能技术。事实上,深度网络虽然是人工智能发展史上的重要里程碑,但距离真正的人工大脑还相去甚远,只是人工智能发展过程中的一个特定阶段而已。

单有结构,人工神经网络是不能表现出智能能力的。就像人类如果只有大脑,而不通过学习手段来武装自已的大脑,则不能解决任何问题一样,人工神经网络同样需要在结构基础上解决学习问题,这便是该项技术中的第二个核心问题,甚至比第一个问题更为重要,可以说结构是基础,而学习是灵魂。当然,结构的基础作用也不容小视,结构的好坏在很大程度上影响着学习效果,比如深度网络中的卷积神经网络正是通过结构的改进,使得传统的误差反向传播学习算法能够获得理想的深度学习效果。因此,网络结构及其学习是相辅相成和密不可分的,人工神经网络的发展既是网络结构的发展,也是学习方法的发展,或者二者的同步发展。人工神经网络的学习技术,本质上说是机器学习技术的一个分

第1章绪论

支,其学习方式同样可从监督学习、非监督学习、半监督学习、强化学习这四种方式来认识和研究,只不过需要针对人工神经网络的特殊性来设计特定的方法而已。此外,目前对于人工神经网络的学习,主要是指对于网络中神经元之间连接权值的学习,网络结构主要依靠人为经验设计。事实上,网络结构也是可以学习的,通过机器学习技术来获得更为理想的网络结构,实现网络结构的自动设计是可能的,但由于实现和计算复杂,且目前未见有效的学习成果,因此在网络结构上的学习尚未引起广泛的关注。而人类大脑的网络结构是否完全预先确定好来作为学习的基础,以及学习是否能改变大脑结构,这还有待更多研究去证实,其真相应是网络结构学习的思想基础。

解决了网络结构问题及其学习问题,就能获得处理具体应用任务的人工神经网络模型。对于人工神经网络的认识和研究,应从这两个关键问题人手。

1.2机器学习简史

如前所述,机器学习与人工神经网络是紧密关联的,尤其从人工神经网络的角度,其与机器学习的发展密不可分,人工神经网络的进步离不开相应机器学习方法的进步,离开了机器学习,也就没有人工神经网络的发展。而机器学习与人工神经网络没有必然关系,机器学习方法可以是针对人工神经网络的,也可以是不针对人工神经网络的。本节介绍除人工神经网络学习以外的机器学习方法的发展,而将人工神经网络的学习归入人工神经网络部分,在第1.3节介绍。

机器学习的研究从20世纪40年代开始,到20世纪80年代逐渐形成一条专门的人工智能实现途径,正如人工智能学科创始人之一麦卡锡(McCarthy)所说:“从20世纪40年代开始,机器学习的思路已被反复提出。最终,这一思路能得到实现。”[3]

1955年,同为人工智能学科创始人之一的萨缪尔(Samuel)首次在计算机博弈问题中引入监督的记忆学习方法,在经典的极大极小博弈搜索算法中,通过记忆棋局状态对应的倒推值,提高了下棋程序的能力。此后,在计算机博弈中运用机器学习方法遂成为一种有效的技术和验证机器学习方法的常用手段,直至监督学习和强化学习方法在2016年引起轰动的AlphaGo围棋程序中的成功应用,推动了机器学习技术的普及。1957年,贝尔曼(Bellman)将马尔科夫决策过程(markov decision process,MDP)引人强化学习,形成贝尔曼公式,成为强化学习的基础。1965年,绍德尔(Scudder)提出半监督的自学习方法,半监督学习概念开始形成。1967年,麦格理(MacQuarie)发明k-均值聚类方法,成为非监督聚类方法中的经典,时至今日仍是最主要的聚类算法之一。1977年,德普斯特

6

人工智能—机器学习与神经网络

(Dempster)提出期望-最大化算法(expectation-maximization,EM)算法,成为重要的解决隐含变量问题的统计学习方法,得到了广泛的应用。同年,瓦普里克(Vapnik)与斯特林(Sterin)提出半监督学习中的转导支持向量机(transductive

SVM)方法,成为半监督学习中的重要手段。

20世纪八九十年代是机器学习逐渐成长为一门独立人工智能分支的阶段,监督学习、非监督学习、半监督学习、强化学习四大类机器学习方法逐渐形成并得到了较大的发展。1986年,昆兰(Quinlan)针对决策树的监督学习,以信息熵为基础,提出了经典的ID3算法。1987年,考夫曼(Kaufman)与诺斯乌(Rous-seeuw)提出了k-中心点聚类方法,以弥补k-均值聚类方法不够鲁棒和易受初值影响的问题。1988年,萨顿(Sutton)提出了强化学习中重要的时序差分(timedifference,TD)算法,成为一大类强化学习方法的基础。1992年,默茨(Mez)等人总结了半监督学习问题及相关方法,首次提出了半监督学习这个术语。同年,在强化学习领域,沃特金斯(Watkins)提出了经典的Q-学习算法,而威廉姆斯(Williams)则提出了基于梯度的策略优化算法REINFORCE,成为以后AlphaGo中所采用的强化学习方法的基础。1994年,鲁梅尼(Rummery)提出了Saras强化学习算法。同年,阿格拉沃尔(Agrawal)与斯利坎特(Skrikant)发明了Apriori算法,成为关联规则挖掘中的经典算法,至今仍得到广泛采用。1995年,瓦普里克(Vapnik)的统计学习理论以及在该理论指导下所衍生的支持向量机(supportvector machine,SVM)学习方法得以成熟,成为当时以及此后一段时期内应用最普及和地位最主流的监督学习思想,直到2006年其统治地位才逐渐被人工神经网络中的深度学习所取代。

非监督学习在这一时期亦继续得到长足发展,一些经典的聚类算法和关联规则挖掘算法被提出。聚类方法方面,层次聚类、基于数据密度的聚类、统计聚类、基于空间网格的聚类等思想及其算法逐渐涌现。1995年,Cheng Yizong提出了著名的均值迁移算法,并应用于非监督聚类。1996年,Tian Zhang提出了BIRCH层次聚类算法,具有递增聚类特性。1996年,伊斯特(Ester)提出了基于数据密度的经典聚类算法DBSCAN。切斯曼(Cheeseman)与舒茨(Stutz)提出了

AutoClass统计聚类算法。1997年,王(Wang),杨(Yang)与芒茨(Muntz)提出了基于空间网格的聚类算法STNG。1998年,古阿(Gua)提出了CURE层次聚类算法,通过采用多个代表数据点表示一个簇来更好地适应数据形状。1998年,海因伯格(Hinneburg)与凯姆(Keim)提出了另一种经典的基于数据密度的聚类算法DENCLUE。赛科霍乐斯拉米(Sheikholeslami)、查特吉(Chatterjee)与张(Zhang)提出了WaveCluster聚类算法。1999年,卡里皮斯(Karypis)发明了结合

层次聚类思想与图聚类思想的聚类算法CHAMELEON。关联规则挖掘方面,巴

···试读结束···

作者:岑桂芳

链接:https://www.58edu.cc/article/1574954707447734273.html

文章版权归作者所有,58edu信息发布平台,仅提供信息存储空间服务,接受投稿是出于传递更多信息、供广大网友交流学习之目的。如有侵权。联系站长删除。